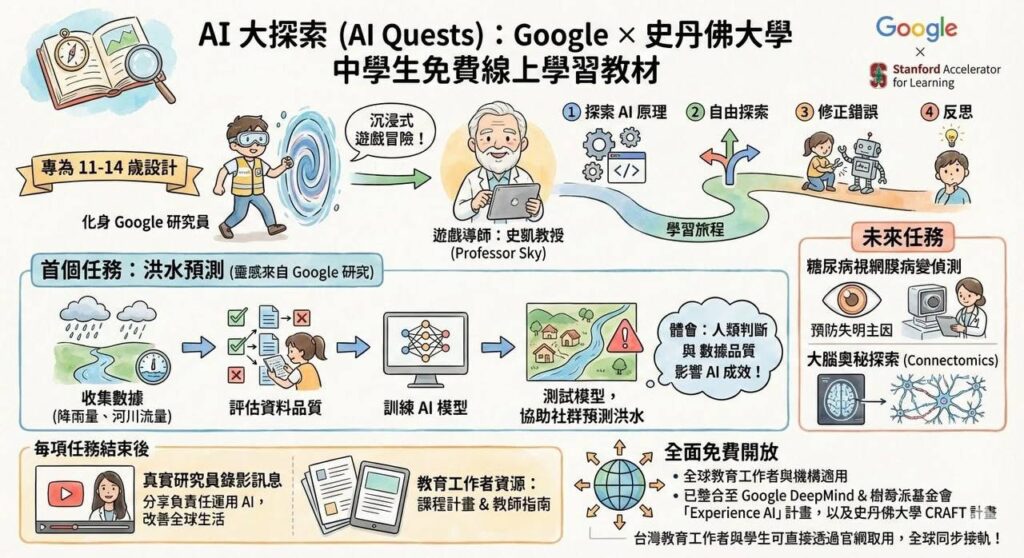

這是一個名為 AI 大探索(AI Quests) 的學習計畫,由 Google × 史丹佛大學(Stanford Accelerator for Learning)共同推出,目標族群明確鎖定 11–14 歲。這個年齡選得非常精準:抽象思維剛成形,但還沒被考試導向扭曲。

一、核心定位:不是教 AI 工具,而是教「像研究員一樣思考」

這套設計最聰明的地方在於:

它完全避開「教模型、教指令、教工具」這條死路。

它改成三個角色轉換:

學生不是使用者 → 是「Google 研究員」

老師不是講師 → 是「遊戲導師(Professor Sky)」

學習不是課程 → 是「任務型探險」

這在企業語言裡叫:認知框架重塑(Cognitive Reframing)。

一開始就把「我在上課」換成「我在解任務」。

二、第一個任務:洪水預測,其實是在偷教 AI 的本質

表面上是「洪水預測」,實際上是完整跑過一次 AI 價值鏈:

- 收集資料(降雨量、河川流量)

→ 讓孩子理解:AI 不吃「答案」,AI 吃「資料」 - 評估資料品質

→ 這一步極關鍵,直接點破一個成人都常犯的錯:

AI 的錯,九成來自資料爛,而不是模型笨 - 訓練模型

→ 不講數學,不講架構,只講「為什麼它會學壞」 - 測試與社會應用

→ 把結果放回「真實世界」,不是交作業,而是救社區

旁邊那個對話框寫得很白:

「人類判斷與數據品質影響 AI 成效」

這句話,很多企業高層到現在還沒懂。

三、學習流程設計:這不是線性課綱,是「反思迴圈」

圖上那條彎彎曲曲的路,標了四件事:

探索 AI 原理 → 自由探索 → 修正錯誤 → 反思

這不是裝飾,這是一個**明確對齊科學方法論(Scientific Method)**的學習閉環。

說白一點:

孩子不是被教「AI 是什麼」,而是被訓練成

能懷疑 AI、修正 AI、反思 AI 的人。

這在今天,是稀缺能力。

四、未來任務選題,完全不是玩票

右邊的「未來任務」選了兩個:

- 糖尿病視網膜病變預測

- 大腦連結體(Connectomics)

這兩個題目有三個共同點:

- 高度真實(不是模擬)

- 高度倫理風險

- 無法只靠「技術」解決

這其實是在偷偷種一顆種子:

AI 永遠不是純工程問題,而是人類決策問題。

五、對你這類「數位教練/教育設計者」的殘酷提醒

這張圖在市場上傳遞了一個很殘酷的訊號:

未來真正有價值的 AI 教學,不是:

- 教 ChatGPT

- 教 Canva

- 教 Prompt

而是:

- 教 任務拆解

- 教 資料品質判斷

- 教 錯誤修正與反思能力

- 教 AI 與社會的交互影響

換句話說,

工具只是介面,思維才是產品。

如果把這張圖當成「國外做得好,我們看看就好」,那是誤判;

它其實是一張未來 5–10 年 AI 教育的設計規格書。

真正值得問的不是「他們怎麼做」,

而是:我們現有的課程,有沒有任何一個環節,真的在訓練這些能力?

這問題,對個人、對組織、對教育體系,都不太好回答。

以下這篇,我會站在「數位教練蔡教練」的位置,不是評論者、不是轉述者,而是把 AI Quests 當成一個「我認可、而且願意拿來對照自己教學的方法論樣板」,寫給老師、企業主管、家長與正在教 AI 的人。

我常在課堂上說一句很不討喜的話:

「會用 AI,不代表你真的懂 AI。」

而 Google 的 AI Quests,正是少數把這句話當成設計起點的教育計畫。

為什麼我會認真看 AI Quests?

原因很現實。

這幾年我教過的學生,從中高齡學員、企業內訓、到第一線行政與主管,幾乎都出現同一個現象:

- 對 AI 充滿期待

- 對 AI 的判斷力卻極度薄弱

- 一旦 AI 給了答案,就傾向直接採用

這不是能力問題,是教育設計出了偏差。

AI Quests 讓我看到一個很清楚的訊號:

真正負責任的 AI 教育,不是教人更快產出,而是教人「什麼時候該踩煞車」。

AI Quests 教的不是 AI,而是「決策責任」

很多人第一眼看到 AI Quests,會以為它是在教孩子做模型、看資料、跑預測。

但如果你仔細拆它的任務結構,會發現一件事:

它真正反覆訓練的,其實只有三件事:

- 這個 AI 為什麼會這樣判斷?

- 這個結果在哪些條件下會失效?

- 如果錯了,誰要負責?

這三個問題,在企業裡是高層該問的問題,在教育裡卻很少被教。

為什麼第一個任務是「洪水預測」?

我非常欣賞這個選題。

洪水預測有三個特性,幾乎是為 AI 素養量身打造的:

第一,它沒有標準答案。

第二,它高度依賴資料品質。

第三,錯了會造成真實世界的損害。

這等於直接告訴學生一件事:

AI 不是考試機器,而是風險放大器。

這個觀念,對孩子重要,對企業更重要。

這套設計,對我做「數位教練」最大的提醒

AI Quests 讓我重新檢視一件事:

我教學時,是不是不小心把 AI 教成「捷徑」,而不是「工具」?

因為一旦 AI 被包裝成捷徑,學員就會開始:

- 跳過思考

- 忽略資料來源

- 把錯誤外包給模型

這在短期內看起來有效率,長期卻會讓組織變笨。

為什麼我現在更強調「流程」而不是「工具」

你會發現,我近一年在課程裡反覆強調的,不是某一個 AI 工具,而是:

- AI 第二大腦

- 任務拆解

- 資料品質判斷

- 人與 AI 的分工邏輯

這其實和 AI Quests 的精神完全一致。

真正的高手,不是會用 AI,而是會建系統。

AI Quests 教的是一套「可以反覆犯錯、但不會失控」的思維流程,這正是企業與教育現場最缺的東西。

給家長、老師、企業主管的一個現實提醒

如果我們現在教孩子、教員工的 AI 內容,仍然是:

- 工具怎麼用

- 功能怎麼開

- 產出怎麼快

那我們其實是在訓練一件危險的事:

對 AI 過度信任,卻不願承擔後果。

AI Quests 提供的不是答案,而是一個清楚的方向:

AI 素養的核心,是能不能在 AI 出現時,仍然保有判斷力。

我會怎麼把 AI Quests 的精神帶進我的教學?

很簡單,但不輕鬆:

- 讓學員看見 AI 出錯

- 刻意使用不完美的資料

- 要求人對 AI 的結果負責

- 把「反思」設計成流程的一部分

這些都不炫技,但都很真實。

結語:AI 教育不是趨勢,是責任

AI Quests 不是給孩子準備未來工作的技能,

而是給社會準備不被 AI 帶偏的公民。

這也是我作為數位教練,越來越確定的一件事:

AI 教學的價值,不在教得多新,而在教得夠穩。

工具會一直換,

但能夠懷疑、修正、反思的人,永遠不會被淘汰。

這,才是我願意為之背書的 AI 教育方向。