更新日期:2025/1/30

Github 連結: https://github.com/deepseek-ai/DeepSeek-V3

線上體驗 DeepSeek V3 https://chat.deepseek.com/

DeepSeek-V3 技術報告總結

DeepSeek-V3 是一個強大的混合專家(MoE)語言模型,總參數量為 671 億,每個令牌激活 37 億參數。該模型採用了多頭潛在注意力(MLA)和 DeepSeekMoE 架構,以實現高效的推理和經濟的訓練。以下是 DeepSeek-V3 的主要特點和成就:

1. 模型架構

- 多頭潛在注意力(MLA):減少鍵值緩存(KV cache)的大小,同時保持與標準多頭注意力(MHA)相當的性能。

- DeepSeekMoE 架構:使用細粒度專家並隔離一些專家作為共享專家,以提高訓練效率。

- 輔助損失無需負載平衡策略:通過動態調整偏置項來確保專家負載平衡,避免性能下降。

- 多令牌預測(MTP):通過預測多個未來令牌來提高模型性能和推理效率。

2. 基礎設施

- 計算集群:使用 2048 個 NVIDIA H800 GPU,通過 NVLink 和 InfiniBand 進行互連。

- 訓練框架:採用 HAI-LLM 框架,支援管道並行、專家並行和數據並行。

- FP8 訓練:首次在極大規模模型上驗證 FP8 混合精度訓練的可行性,顯著降低訓練成本和記憶體使用。

3. 訓練策略

- 數據構建:使用 14.8 億兆高品質和多樣化的令牌進行預訓練。

- 超參數設置:詳細描述了預訓練、上下文延展和後訓練的超參數設置。

- 上下文延展:分兩個階段將上下文長度延展至 32K 和 128K。

- 後訓練:包括監督微調(SFT)和強化學習(RL),並引入獎勵模型和自我獎勵機制。

4. 評估與性能

- 評估基准:在多個標準和開放評估基准上進行評估,涵蓋知識、代碼、數學和推理等領域。

- 性能表現:DeepSeek-V3 在開放源碼模型中表現最強,特別是在代碼和數學領域,並與領先的閉源模型(如 GPT-4 和 Claude-3.5-Sonnet)表現相當。

5. 經濟高效的訓練成本

- 總訓練成本:僅需 2.788 萬個 H800 GPU 小時,假設 H800 GPU 的租用價格為每小時 2 美元,總訓練成本約為 557.6 萬美元。

- 穩定訓練:整個訓練過程穩定,未出現不可恢復的損失波動或回滾情況。

6. 貢獻與未來方向

- 貢獻:提出輔助損失無需負載平衡策略、多令牌預測訓練目標、FP8 混合精度訓練框架和高效的訓練基礎設施。

- 未來方向:探索硬件設計建議,如通信硬件和計算硬件的改進,以進一步提升訓練和推理效率。

DeepSeek-V3 是一個強大且經濟高效的語言模型,其在架構、訓練和部署方面的創新為未來大規模語言模型的發展提供了寶貴的參考。

相關連結:

- 超越GPT-4o的开源模型?DeepSeek V3:671B参数量的大语言模型详解 https://www.youtube.com/watch?v=M9LuOqQ478Q

DeepSeek真能终结AI算力时代?‘大力出奇迹’LLM神话就此破灭? https://www.youtube.com/watch?v=GukZCGz2QCM

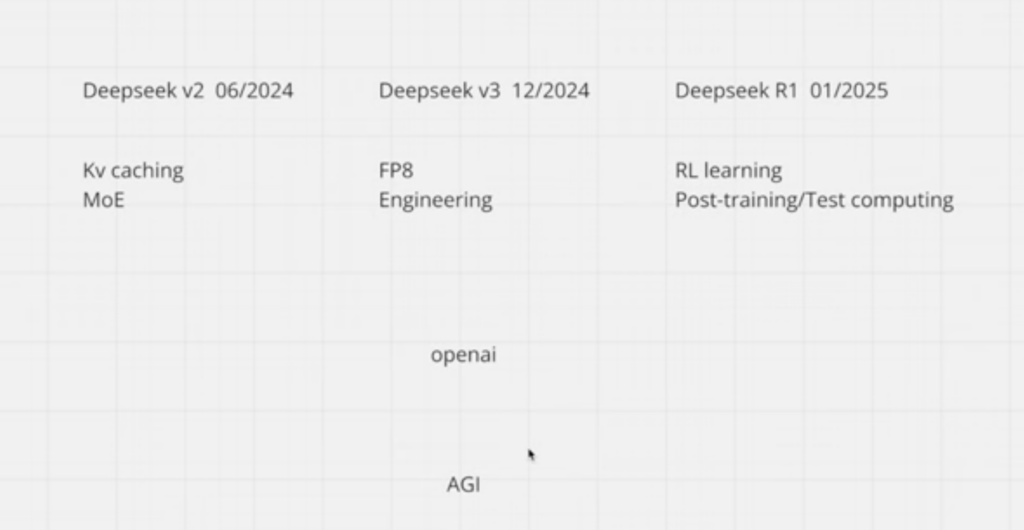

pretraining vs post training ,v3 vs r1 ,作為pretraining的v3 200萬小時是降低精度的效果與32位的llama3.3是一個數量級,r1是基於v3的post training,這種算力需求與訓練算力不一樣,大部分人搞不清基本概念,所以工程上積累的經驗使得dp團隊可以完成fp8的訓練才是dp團隊的核心競爭力,並沒有打破scaling law算力法則。

在深度學習領域,預訓練(Pre-training)與後訓練(Post-training)是模型開發的兩個關鍵階段。預訓練階段,模型在大規模數據集上進行初始學習,旨在捕捉廣泛的知識和模式。後訓練階段,則針對特定任務進行微調,以提升模型在特定應用上的性能。

以DeepSeek公司為例,其近期發布的DeepSeek-V3模型在預訓練階段使用了約200萬小時的計算資源,與32位精度的Llama 3.3模型相比,計算量相當。隨後,基於V3模型,DeepSeek推出了DeepSeek-R1,該模型在後訓練階段採用了強化學習技術,顯著提升了模型的推理能力。

值得注意的是,後訓練階段的計算需求與預訓練階段有所不同。在後訓練中,DeepSeek團隊利用了FP8(8位浮點數)精度進行模型訓練。FP8數據格式相較於傳統的FP16或FP32,能夠提供更高的計算效率,同時降低內存佔用,這使得模型訓練和推理過程更加高效。

然而,FP8精度的應用也面臨挑戰。由於其數值表示範圍較小,精度較低,因此需要引入動態縮放等技術,以確保在加速計算的同時,維持模型的精度和穩定性。

總結而言,DeepSeek團隊在工程實踐中積累的經驗,使其能夠成功應用FP8精度進行模型訓練,這成為其核心競爭力之一。然而,這並未打破深度學習領域的算力規模定律(Scaling Law),而是通過技術創新,在現有框架下實現了更高的效率和性能。

中國AI新創公司DeepSeek(深度求索)橫空出世,直接屠殺科技股,血洗輝達NVIDIA股價、台積電ADR美股,讓黃仁勳身價下跌。沒想到,同行、另一家AI新創公司創辦人爆料,DeepSeek私下偷用「5萬顆輝達H100晶片」!

根據《CNBC》報導,中國AI新創公司「Scale AI」創辦人Alexandr Wang爆料,DeepSeek擁有約5萬個輝達H100晶片,不過這些AI晶片早在2022年拜登政府時期,就已經被限制出口管制措施,並無法出口給中國的公司,「我覺得這是真的,因為他們的籌碼,的確比其他人預期的還要多。」

【人工智能】OpenAI指責DeepSeek不正當使用數據 | DeepSeek火爆引發風波 | 大模型蒸餾 | 美AI專家反對 | 意大利下架 | Anthropic CEO萬字檄文 https://www.youtube.com/watch?v=4iq_s7501XU

【第379期】大模型的 #蒸馏 (Distillation)及 #DeepSeek 遭遇的指控 https://www.youtube.com/watch?v=jsLdkrM6RB8

針對DeepSeek使用知識蒸餾技術所引發爭議的正式回顧與說明,期望能提供更全面的企業視角:

知識蒸餾

知識蒸餾是從成熟模型(教師模型)中擷取關鍵知識,並遷移到學生模型的過程。此技術本身並不涉及對整個原始系統架構的抄襲,而是聚焦於精華概念的重新訓練與整合,以提升學生模型的效能與學習效率。

DeepSeek爭議

DeepSeek被指控透過大規模調用OpenAI API來獲取教師模型的輸出,再進一步蒸餾知識。此舉引發對其道德及合法合規性的質疑,尤其在資安與智慧財產權範疇,存在相對敏感的灰色地帶。企業領導者在採用類似技術時,宜審慎評估合約條款與外部資源的使用範圍。

發展潛力

若技術應用得當,DeepSeek的學生模型不僅能融會原有知識,更可能在結構設計與學習過程中優化,甚至在部分特定場景超越教師模型。這顯示未來若能配合合規性與商業策略,知識蒸餾仍具深厚潛在價值。謹以此為基礎,建議持續投入研發與監管,方能在激烈的AI競局中脫穎而出。